:158-6721-8818 0574-27676908

:158-6721-8818 0574-27676908

NVIDIA TESLA V100

欢迎进入人工智能时代

发现隐藏在海量数据中的深刻见解或将革新整个行业,从个性化癌症治疗到帮助虚拟个人助手自然交谈和预测下一次超强飓风。

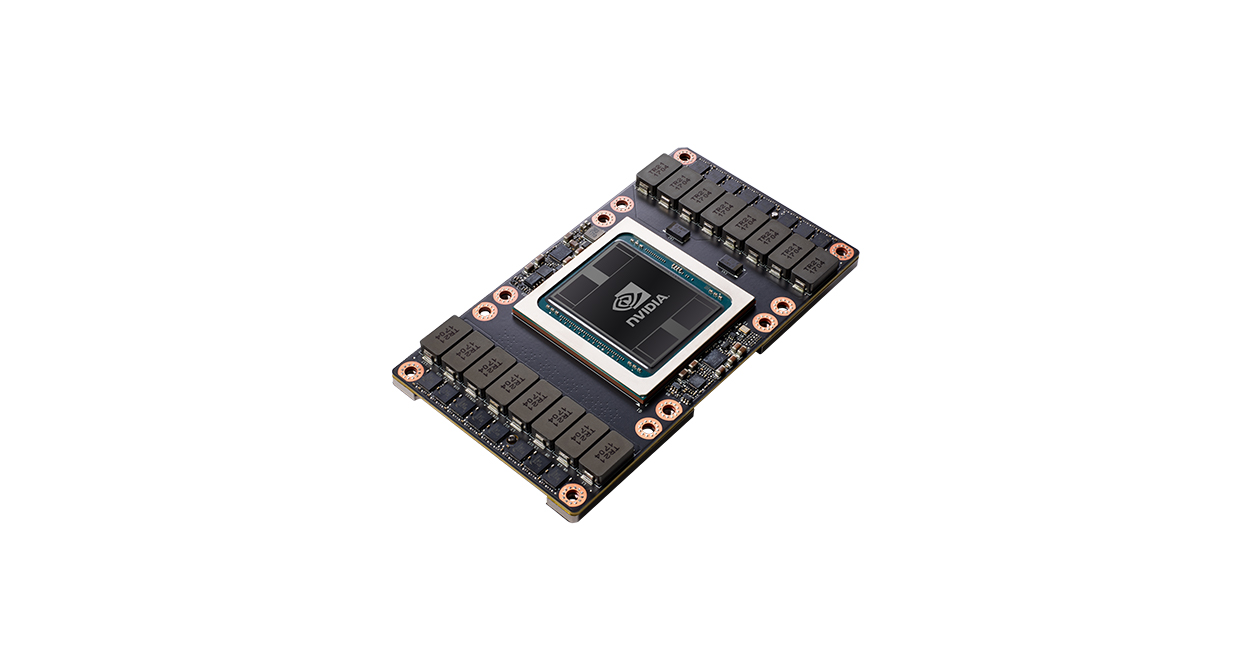

NVIDIA® Tesla® V100 Tensor Core 是有史以来极其先进的数据中心 GPU,能加快 AI、高性能计算 (HPC) 和图形技术的发展。其采用 NVIDIA Volta 架构,并带有 16 GB 和 32GB 两种配置,在单个 GPU 中即可提供高达 100 个 CPU 的性能。如今,数据科学家、研究人员和工程师可以减少优化内存使用率的时间,从而将更多时间用于设计下一项 AI 突破性作品。

人工智能训练

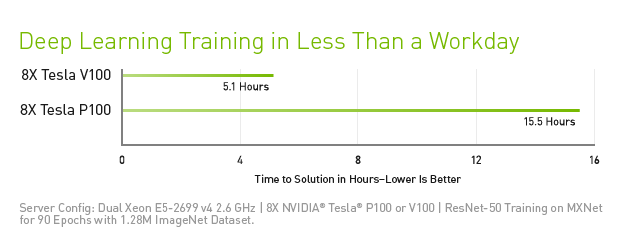

从语音识别到训练虚拟个人助理和教会自动驾驶汽车自动驾驶,数据科学家们正利用人工智能解决日益复杂的挑战。解决此类问题需要花大量时间密集训练复杂性飞速增长的深度学习模型。

Tesla V100 拥有 640 个 Tensor 内核,是世界上第一个突破 100 万亿次 (TFLOPS) 深度学习性能障碍的 GPU。新一代 NVIDIA NVLink™ 以高达 300 GB/s 的速度连接多个 V100 GPU,在全球打造出功能极其强大的计算服务器。现在,在之前的系统中需要消耗数周计算资源的人工智能模型在几天内就可以完成训练。随着训练时间的大幅缩短,人工智能现在可以解决各类新型问题。

人工智能推理

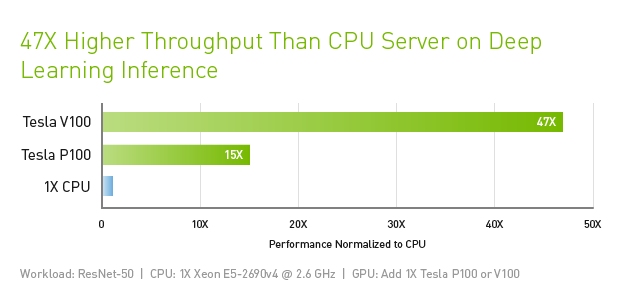

为了利用最相关的信息、服务和产品加强人与人之间的联系,超大规模计算公司已经开始采用人工智能。然而,及时满足用户需求是一项困难的挑战。例如,全球最大的超大规模计算公司最近估计,如果每个用户一天仅花费三分钟时间使用其语音识别服务,他们便需要将数据中心的容量翻倍。

我们设计 Tesla V100 就是为了在现有的超大规模服务器机架上提供更高的性能。由于将人工智能作为核心,Tesla V100 GPU 可提供比 CPU 服务器高 30 倍的推理性能。这种吞吐量和效率的大幅提升将使人工智能服务的扩展变成现实。

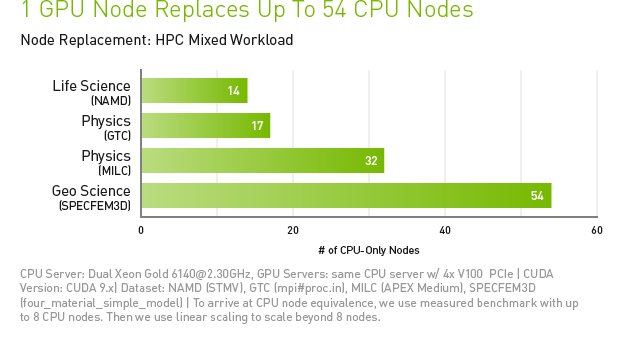

高性能计算 (HPC)

高性能计算是现代科学的基石。从天气预报到发现药物和发现新能源,研究人员使用大型计算系统来模拟和预测我们的世界。人工智能可让研究人员分析大量数据,在仅凭模拟无法完全预测真实世界的情况下快速获取见解,从而扩展了传统的高性能计算。

Tesla V100 的设计能够融合人工智能和高性能计算。它为高性能计算系统提供了一个平台,在用于科学模拟的计算机科学和用于在数据中发现见解的数据科学方面表现优异。通过在一个统一架构内搭配使用 NVIDIA CUDA® 内核和 Tensor 内核,配备 Tesla V100 GPU 的单台服务器可以取代数百台仅配备通用 CPU 的服务器来处理传统的高性能计算和人工智能工作负载。现在,每位研究人员和工程师都可以负担得起使用人工智能超级计算机处理最具挑战性工作的做法。

数据中心 GPU

NVLINK 接口的 NVIDIA TESLA V100

为深度学习提供卓越性能

PCIe 接口的 NVIDIA TESLA V100

通用性出众适合处理各种工作负载

NVIDIA TESLA V100 规格

NVLink 版本 Tesla V100 PCIe 版本 Tesla V100

NVIDIA GPU 加速

带来高性能

双精度 双精度

7.8 TeraFLOPS 7 TeraFLOPS

单精度 单精度

15.7 TeraFLOPS 14 TeraFLOPS

深度学习 深度学习

125 TeraFLOPS 112 TeraFLOPS

双向互联带宽

NVLINK PCIE

300 GB/s 32 GB/s

GPU 内存

显存带宽

容量

32/16 GB HBM2

带宽

900 GB/s

功率

最大功耗

300瓦特 250瓦特

版权所有© 2016 宁波海曙光信电子科技有限公司 浙ICP备14008261号 ![]() 公安备案号:33020302000197

公安备案号:33020302000197

无忧退换货

7天内可退货,15天内可换货

全国联保

在线保修,直达品牌售后

电 话:158-6721-8818

电 话:0574-27676908

联系地址:海曙区东渡路29号8楼D01

配送方式

配送方式:自提、上门配送

配送时间:一般2-3天到货。

关于我们

宁波海曙光信电子科技有限公司是以IT高科技产业为主导,专业为企业提供信息化解决方案及设备

联系方式